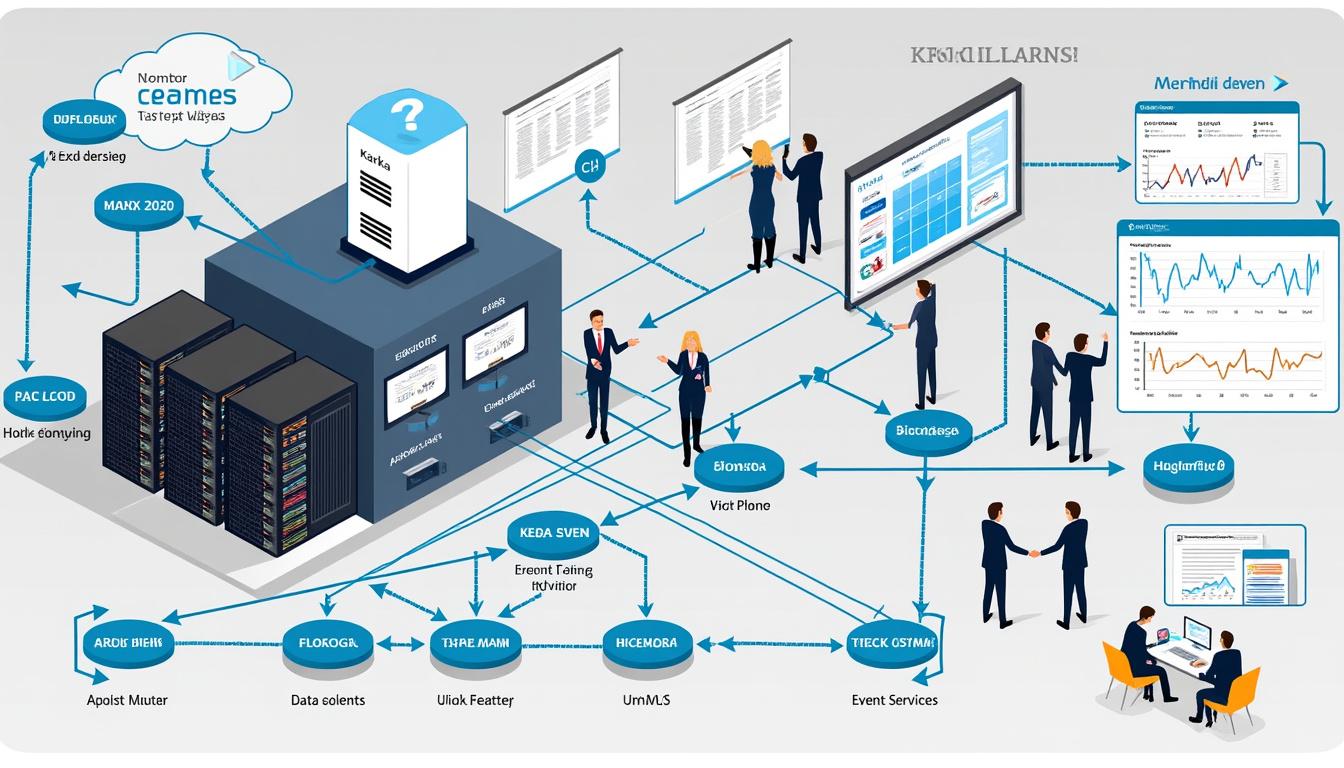

Dans le contexte actuel du Big Data, les entreprises se tournent de plus en plus vers des solutions qui leur permettent de gérer efficacement les flux de données en temps réel. Parmi celles-ci, l’architecture basée sur l’event sourcing associée à Apache Kafka émerge comme une réponse pertinente aux défis liés à la gestion des données. Cette approche offre de nombreux avantages, notamment en termes de traçabilité, de résilience et de flexibilité. En effet, en enregistrant chaque changement sous forme d’événements, les organisations peuvent maintenir un historique des données tout en assurant leur intégrité. Cet article explore pourquoi cette méthode devient essentielle pour les entreprises d’aujourd’hui.

Event sourcing Kafka : une solution pour l’architecture basée sur les événements

Le concept d’event sourcing repose sur l’idée que chaque changement d’état au sein d’une application est consigné sous la forme d’événements immuables. Lorsque l’on associe cette méthode à Apache Kafka, une plateforme de streaming distribuée, les entreprises peuvent non seulement capturer ces événements, mais aussi les traiter en temps réel. Cela transforme la manière dont les systèmes interagissent avec les données en rendant chaque statut historiquement disponible.

Une des principales forces de cette approche est sa capacité à gérer les changements fréquents et massifs dans les données. Par exemple, dans le secteur du e-commerce, chaque interaction de l’utilisateur peut être enregistrée comme un événement. De l’ajout d’un produit au panier à la finalisation d’un achat, chaque étape est traçable, permettant une analyse approfondie du comportement client. Les entreprises telles que Capgemini et Orange Business intègrent déjà cette méthodologie dans leurs applications pour améliorer l’expérience utilisateur et augmenter la réactivité face aux demandes du marché.

Les avantages clés de l’event sourcing avec Kafka

Adopter une architecture d’event sourcing avec Kafka offre plusieurs avantages non négligeables :

- Traçabilité complète : Chaque événement étant enregistré dans l’ordre où il s’est produit, cela permet une vision claire de l’historique des modifications.

- Scalabilité : Kafka étant conçu pour traiter des flux de données massifs, il devient facile d’adapter le système selon les besoins croissants d’une application.

- Résilience : En cas de panne ou de défaillance, la reconstruction de l’état d’un système à partir des événements est rapide et efficace, minimisant les interruptions de service.

Un autre exemple d’application de cette technologie peut être observé dans le secteur bancaire avec des entreprises comme Murex et Sopra Steria. Elles utilisent l’event sourcing pour effectuer des transactions en temps réel tout en veillant à conserver un historique fiable des opérations, ce qui est indispensable pour la conformité réglementaire et la prévention de la fraude.

Différences clés entre event sourcing Kafka et autres modèles de gestion des données

Pour mieux comprendre l’impact de l’event sourcing associé à Kafka, il est important de le comparer avec d’autres méthodes de gestion des données. Par rapport à des approches classiques comme la base de données relationnelle ou la gestion d’état, l’event sourcing présente des différences marquantes.

Comparaison des modèles

| Critères | Event Sourcing | Modèles traditionnels |

|---|---|---|

| Traçabilité | Historique complet des événements | Mise à jour d’un état sans historique |

| Récupération d’état | Reconstruction à partir des événements | Accès direct à l’état actuel |

| Scalabilité | Haute scalabilité et traitement en temps réel | Difficulté à gérer la montée en charge |

Un autre aspect à considérer est que l’event sourcing peut nécessiter un surcroît d’investissement initial en termes d’architecture et de formation, mais cet investissement est rapidement compensé par une agilité accrue et une meilleure adaptabilité aux demandes du marché. Les entreprises telles que Dataiku et Atos mettent en avant la capacité de cette approche à soutenir une innovation continue, en permettant de tester rapidement de nouvelles idées de produits sans perturber les opérations existantes.

L’avenir de l’event sourcing Kafka dans le développement d’applications

La tendance actuelle dans le développement d’applications est de se concentrer sur la réactivité et le traitement des données en temps réel. L’event sourcing avec Apache Kafka s’inscrit parfaitement dans cet objectif. Les entreprises aspirent à créer des systèmes qui non seulement collectent des données, mais qui réagissent dynamiquement à ces données.

L’impact sur le développement logiciel

En intégrant l’event sourcing dans le cycle de développement logiciel, les équipes peuvent faire des itérations plus rapidement et réduire les temps de déploiement, tout en offrant une meilleure qualité de produit. Les tests deviennent également plus simples, car chaque événement peut être vérifié indépendamment. Cela permet, par exemple, à des sociétés comme OVHcloud et Scaleway d’innover sans compromettre la stabilité de leurs systèmes.

Voici quelques tendances à surveiller dans ce domaine :

- Automatisation des processus : Les systèmes basés sur des événements permettent de déclencher automatiquement des workflows en réponse à des événements spécifiques.

- Intelligence Artificielle : L’analyse des données en temps réel peut alimenter des algorithmes d’IA pour prédire des comportements ou identifier des anomalies.

- Intégration continue : L’architecture permet dès à présent des déploiements fréquents sans interruption de service, contribuant à une approche DevOps plus agile.

Non seulement cette approche transforme les opérations internes des entreprises, mais elle leur permet également de se positionner comme leaders dans un environnement de plus en plus compétitif. La compréhension des flux d’événements et leur exploitation deviennent des facteurs clés de succès dans le développement futur des applications.

Comprendre comment event sourcing Kafka transforme la gestion des données

L’adoption de l’event sourcing avec Kafka a entraîné une révolution dans la façon dont les entreprises gèrent leurs données. Ce changement est marqué par un passage d’une architecture centrée sur l’état à une architecture orientée événements.

Transformation de la gestion des données

Avant la montée en puissance de cette approche, les entreprises faisaient souvent face à des limitations dans la gestion des données. Avec des systèmes hétérogènes et des bases de données rigides, les possibilités d’analyse et d’optimisation étaient souvent freinées. Grâce à l’event sourcing, chaque modification est capturée et peut être traitée en temps réel pour en tirer des insights précieux.

Les insights obtenus peuvent être utilisés pour créer des rapports, prédire des tendances ou détecter des anomalies. Par exemple, des entreprises comme Databricks utilisent cette méthodologie pour maximiser la valeur de leurs données en offrant des services d’analyse avancée. En intégrant des flux d’événements dans leurs solutions, elles facilitent une prise de décision basée sur les données au bon moment.

Voici quelques applications pratiques de l’event sourcing dans la gestion des données :

- Analyse en temps réel : Les entreprises peuvent désormais répondre instantanément aux comportements des utilisateurs.

- Mise en conformité : L’enregistrement des événements aide à respecter les réglementations de manière plus efficace.

- Optimisation des processus : Chaque événement peut également être utilisé pour améliorer continuellement le fonctionnement organisationnel.

Le passage à cet état d’esprit événementiel n’est pas seulement technique, il implique également un changement culturel au sein des entreprises, redéfinissant ainsi leur approche des données.

Comment l’event sourcing avec Kafka optimise vos performances

D’un point de vue opérationnel, l’event sourcing associé à Kafka offre des performances inégalées, transformant les méthodes de travail des entreprises. Le traitement continu des événements permet aux organisations non seulement de fonctionner plus efficacement, mais également d’améliorer la qualité des services offerts à leurs clients.

Amélioration des performances opérationnelles

Une mise en place réussie de l’event sourcing permet d’automatiser de nombreuses tâches manuelles, réduisant ainsi le risque d’erreurs et augmentant la productivité. Ceci est particulièrement pertinent dans des contextes où le temps réel est une exigence, comme dans les systèmes de réservation aérienne ou les plateformes de trading financier.

Les bénéfices tangibles peuvent être mesurés à travers plusieurs KPI (indicateurs clés de performance), tels que :

- Temps de réponse réduit : Les systèmes peuvent traiter des millions d’événements par seconde.

- Fiabilité accrue : Les architectures basées sur des événements sont généralement plus robustes face aux défaillances.

- Coût de maintenance diminué : Moins de dépendances entre les systèmes rendent la gestion et la mise à jour plus simples.

C’est pourquoi des entreprises telles que Confluent sont au premier plan, proposant des solutions visant à intégrer et optimiser l’utilisation de Kafka dans les flux de travail des entreprises.

Qu’est-ce que l’event sourcing ?

L’event sourcing est une approche de gestion des états dans les applications, où chaque changement d’état est enregistré sous la forme d’événements.plè chacun de ces événements contient des données sur ce qui s’est passé, permettant ainsi de reconstruire l’état de l’application à tout moment, en se basant sur l’historique des événements.

Quels sont les défis associés à l’event sourcing ?

Bien que l’event sourcing présente de nombreux avantages, il existe des défis potentiels tels que la complexité de la gestion des événements à grande échelle et la nécessité de garantir l’ordre des événements. Les entreprises doivent également s’engager dans une réflexion approfondie sur la conception de leur modèle basé sur des événements pour éviter des problèmes futurs.

Pourquoi choisir Kafka pour l’event sourcing ?

Kafka se distingue par sa capacité à traiter des flux massifs d’événements tout en étant facilement scalable. Sa résilience et sa flexibilité en font le choix idéal pour les entreprises souhaitant adopter une architecture orientée événements.